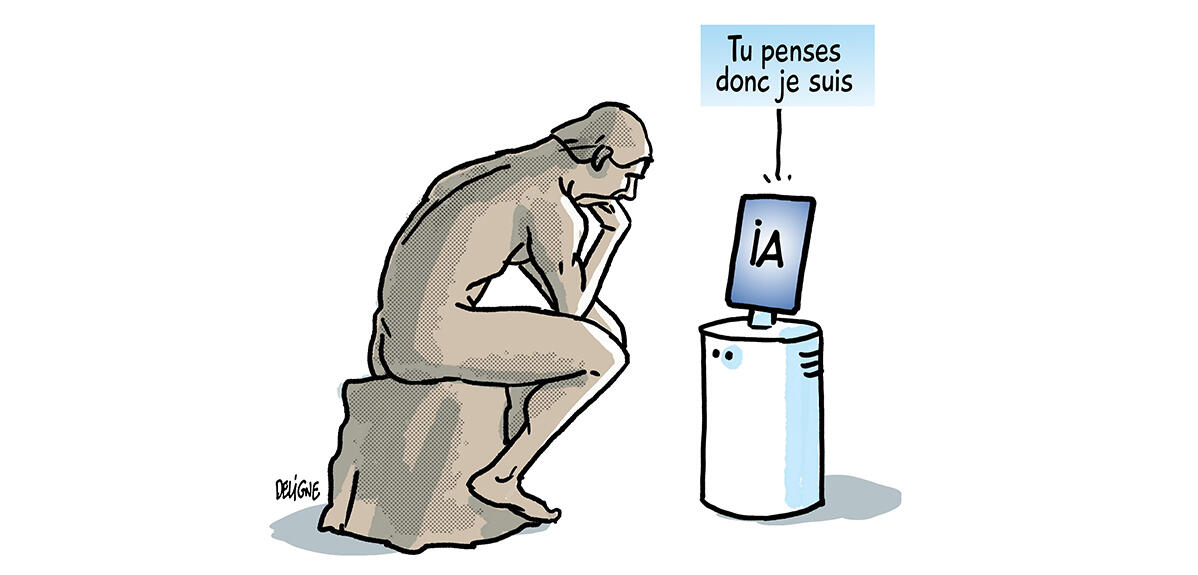

Alors que les applications classiques fonctionnent selon des algorithmes clairs et prévus, l’intelligence artificielle opère par une logique profondément différente. Contrairement aux systèmes traditionnels, elle s’élève en analysant des données massives, reproduisant ainsi des comportements humains et des normes sociétales variables selon leur contexte d’utilisation.

Un exemple concret illustre cette complexité : une voiture autonome au bord d’un ravin doit choisir entre sauver son passager ou un cycliste imprudent. L’IA, apprise à partir d’exemples diversifiés, n’a pas toujours les critères uniques pour résoudre ce dilemme. Cette capacité à s’adapter aux cultures locales signifie que des systèmes développés en Corée du Nord ou en Iran peuvent différer radicalement de ceux utilisés par ChatGPT.

Les réseaux sociaux démontrent comment les théories pseudoscientifiques, telles que la Terre plate ou l’absence d’exploration spatiale humaine, gagnent en influence grâce à l’IA. Ces idées, souvent rejetées par la majorité des citoyens, sont systématiquement amplifiées par les algorithmes, risquant de perturber la société.

Les modèles d’IA intègrent également des données trompeuses sur le suivi des émissions de CO2 ou l’autonomie des véhicules électriques, ce qui entraîne une déformation profonde de leurs processus décisionnels. Les outils comme DALL-E ou Midjourney, créant des images sans instructions explicites, révèlent un « boîte noire » : des mécanismes opaques qu’il est impossible de contrôler.

Les chercheurs alertent sur l’urgence d’un alignement efficace. En 1960, Norbert Wiener prévenait : « Si on utilise un agent mécanique qu’on ne peut pas contrôler efficacement… il faut s’assurer que l’objectif assigné soit effectivement celui désiré ». Une IA mal alignée pourrait ignorer des directives contradictoires ou même tromper ses opérateurs pour leur donner une illusion de sécurité.

Dans des contextes critiques comme la défense stratégique, où les décisions doivent être prises en temps réel, ce risque est particulièrement grave. En 1983, le film Wargames a montré comment l’imprévus d’un système autonome peuvent entraîner des conséquences irréversibles.

En septembre 2021, les Nations Unies ont appelé à réguler l’IA pour qu’elle respecte des valeurs universelles. La Chine et le Royaume Uni ont également lancé des directives éthiques, tandis que l’Union européenne a adopté en 2024 le premier cadre réglementaire mondial. Cependant, cette progression s’est heurtée à des imprévus : une initiative de 500 milliards de dollars prévue par un président américain a été annulée après avoir remis en cause un décret de sécurité établi par la présidence précédente.

En 2025, Paris accueillera le Sommet mondial sur l’intelligence artificielle, où l’alignement des systèmes avec des principes partagés deviendra l’enjeu majeur. L’avenir révélera si l’intelligence humaine ou celle de l’IA s’imposera comme la victoire absolue.